Da nube á terra, Galicia explora algoritmos que freen o dano ao planeta: «Na competición polo mellor ''chatbot'', non quero pensar nos recursos que están a empregar»

MERCADOS

Son referentes nas súas respectivas disciplinas e uníronse nun grupo de investigación que aspira a posicionarse a nivel global no desenvolvemento dunha intelixencia artificial de baixo consumo

19 may 2024 . Actualizado á 09:28 h.Para comprender a magnitude do reto, o primeiro é preguntarse: Que entendemos por industria contaminante? A imaxe que probablemente vinga á nosa cabeza é a dunha cheminea expulsando fume. Unha situación que non asociamos nin á rede nin aos dispositivos grazas aos que producimos e difundimos esta noticia. A nube e internet parecen brancos e etéreos, pero para que a conexión non falle e a información gárdese fan falta toneladas de cobre, cables que atravesan océanos e centros de datos que ocupan áreas quilométricas. A modo de exemplo, o data center máis grande de Europa, en Kolos (Noruega), abarca dous millóns de metros cadrados. Co bum da intelixencia artificial e o uso popular de aplicacións como ChatGPT as cifras de auga, enerxía e emisións de CO2 dispáranse.

Con todo, a sociedade está lonxe de asimilar aínda que detrás dun clic hai, ademais de moita ciencia, inxentes recursos. Por iso, no grupo formado por unha vintena de investigadores da Universidade da Coruña (UDC) que lidera a enxeñeira informática Verónica Bolón Canedo (Carballo, 1984), desde o 2022 membro da Real Academia de Ciencias Exactas, hai expertos en lingüística, dereito, psicoloxía ou economía, ademais de matemáticos e informáticos. «Hai moitísimos custes enerxéticos ocultos detrás da tecnoloxía», introduce Bolón.

O seu equipo opera no Centro de Investigación TIC (Citic), vinculado á universidade e xerme dun puñado de spin-offs de base tecnolóxica na Coruña, a cidade elixida polo Goberno para albergar a Axencia Española de Supervisión da Intelixencia Artificial (Aesia), a primeira de Europa. O campo da intelixencia artificial sostible no que son un dos grupos científicos pioneiros afronta o 2024 cunha boa noticia. O Ministerio para a Transformación Dixital concedeulles unha das 21 cátedras da Estratexia Nacional en Intelixencia Artificial (ENIA) para o seu proxecto: a Cátedra UDC-Inditex sobre algoritmos verdes, ou como desenvolver aplicacións de intelixencia artificial de baixo consumo. A súa proposta foi a segundo mellor valorada e ten o respaldo de Inditex, que os financiará, polo menos outro ano máis, cando en decembro do 2025 esgoten os 900.000 euros procedentes dos Next Generation.

Os dous camiños

«Esta investigación sáese do que están a facer as grandes multinacionais», sostén Verónica Bolón. Ante a carreira que lideran Microsoft, Google e OpenAI (a empresa que fundaron, entre outros, Elon Musk e Sam Altman e que está detrás do fenómeno ChatGPT), o seu equipo científico vai ao contraxeito. «Cando envías unha consulta a ChatGPT, hai un consumo. Pero, ademais, está o tempo de aprendizaxe dos algoritmos. En grandes modelos poden ser meses, isto require de súper ordenadores en grandes centros de datos que consumen cantidades inxentes de enerxía así como de auga para a súa refrixeración. Na competición polo mellor chatbot, non quero pensar nos recursos que están a empregar», explica a enxeñeira.

Para amortecer este impacto aspiran a ser un referente internacional en intelixencia artificial verde. No seu estudo abordan dous campos de actuación. Por unha banda, «queremos que os algoritmos sexan máis eficientes de xeito que usen menos datos e a súa aprendizaxe dure menos», detalla Verónica. Este é o primeiro paso.

Ademais, hai que ter en conta que «o software fai os cálculos, obriga a facer as operacións, é o hardware realmente o que contamina». Os grandes modelos de intelixencia artificial necesitan cartóns gráficos moi potentes, «cuns chips que fan operacións moi complexas. Na industria xa se traballa para conseguir tarxetas máis eficientes partindo dunha forma de almacenar os datos máis efectiva», continúa Bolón.

No seu equipo conseguiron executar algoritmos que se realizan cos 64 bits habituais dun computador con 32 ou 16 bits sen perder precisión. «O bit é a unidade de información más pequena. Temos experimentos mesmo con 8 bits. Isto fai que os ordenadores sexan máis rápidos, consuman menos e precisen menos almacenamento. Abre a porta a empregar dispositivos pequenos no lugar de enviar todo a súper computadoras. Segundo o caso, penso que hai que comezar a pensar se paga a pena adestrar un algoritmo para que mellore un 0,01 % un rendemento. Non é o mesmo intentar detectar unha enfermidade que recomendar unha serie en Netflix», salienta Bolón.

Na segunda vertente da cátedra entran en xogo investigadores como o estatístico Javier Tarrío. «Buscamos facer máis eficientes enerxeticamente os edificios. Os algoritmos axudan a que as instalacións sexan máis sostibles», aclara o matemático. A intelixencia artificial, por tanto, tamén pode ser parte da solución.

«Achegamos ferramentas estatísticas que detectan anomalías. O noso combustible son os datos que recollen os sensores. Cando reduces o consumo de enerxía, reduces as emisións», argumenta o matemático. E os gastos na factura. Por iso, enerxéticas e instaladoras traballan desde hai tempo con investigadores da universidade. «Foron as primeiras compañas que contactaron connosco. Ofrecen as aplicacións que desenvolvemos a hospitais, hoteis ou multinacionais. A partir de plataformas web conectadas a sensores reciben información en tempo real de todas as súas instalacións: de temperatura, humidade, consumo de cada sala ou climatización», precisa Tarrío.

«Un dos potencias da intelixencia artificial é a predición. Se podes predicir cando vai haber un pico de consumo, iso axuda a optimizar os recursos. Por exemplo, nunha tenda. Pero isto non ten por que aplicarse só ao ámbito privado. Tamén ao público. Podemos saber cales son as rúas máis transitadas e a que horas nunha cidade», indica Verónica Bolón, en relación ás smart cities ou cidades intelixentes.

Aínda que boa parte dos integrantes do grupo que busca algoritmos que danen menos o planeta están vinculados ao Citic, un dos centros investigadores recoñecidos como singulares en Galicia e onde a cifra de científicos aproxímase aos 300, tamén hai profesionais doutras facultades e campus da UDC.

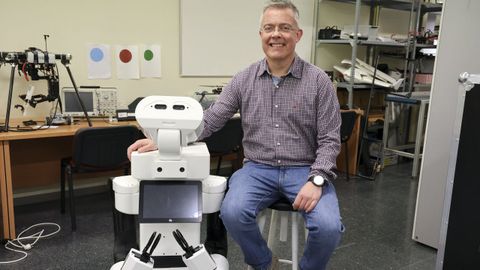

Desde Ferrol, o experto en robótica Richard Duro achega a súa experiencia coa arquitectura cognitiva. «A intelixencia artificial non son só redes profundas ou neuronais. É dicir, unha forma de procesado que trata de imitar as redes neuronais humanas onde a filosofía é: aprender de cero, como os nenos. Hai un problema nisto, os humanos non o aprendemos todo desde cero, vimos con moitas capacidades programadas. Estamos predispostos a falar ou tomar o peito, morreriamos se tivésemos que aprender todo de cero. Se queres un sistema cognitivo de verdade tes que incluír o noso coñecemento, que é un coñecemento de especie. Como se introduce nos robots? Desde hai 40 anos búscanse xeitos de acadalo. E niso estamos», explica Duro.

Os sistemas robotizados van seguir implantándose na nosa industria e na nosa vida. É algo imparable. Unha das contrapartidas é que, tanto na súa fabricación como no seu uso, «o consumo de enerxía é moito maior que nun computador», incide. Ademais, ao ser dispositivos moi complexos, están feitos practicamente para unha única tarefa, «por iso, buscamos xerar robots máis autónomos, que se adapten a diferentes tarefas con moi poucas indicacións do usuario. Así necesitaremos fabricar menos. Pero, para chegar aquí teñen que ter unha capacidade cognitiva en contornas humanas que aínda non hai, pero empeza a albiscarse», avanza o investigador.

Só importa a persoa?

Todo vai enfocado a reducir a pegada de carbono. Segundo un estudo da Universidade de Copenhague, unha única sesión de adestramento de GPT-3 (a base de ChatGPT) ten un consumo enerxético equivalente ao de 126 casas danesas nun ano. Outro da Universidade de Lancaster eleva ao 20% as emisións de CO2 das tecnoloxías da información, máis que a industria da aviación. Non só iso, estima que para o 2025 as emisións polo uso da internet serán similares ás que xere o cuarto país con maior impacto ambiental do mundo, por detrás soamente dos Estados Unidos, China e India.

«Canto contamina adestrar un algoritmo? Hai moitos datos que non se están a revelar por parte destas compañías, pero si sabemos que unha consulta en ChatGPT contamina moito máis que unha en Google, que o vai facer igual e de forma máis eficiente. Por exemplo, para unha tradución. A xente non é consciente disto. Alarmámonos polas emisións dos voos, pero non por isto. Hai que traballar a concienciación», ilustra Bolón.

A contagotas vanse coñecendo algunhas cifras, como as que ofrece o AI Index Report 2024 da Universidade de Stanford (EE.UU.) Ningúns dos titulares que guinda teñen que ver co gasto estimado en millóns de dólares do adestramento de modelos de intelixencia artificial. Unha cantidade que se disparou entre o 2017 e o 2023. No informe, elevan a 78.352.034 dólares o custo de adestramentos de modelos GPT-4 (o modelo de linguaxe de OpenAI que segue á versión de GPT-3); en 191.400.000 os de Gemini Ultras (de Google) e en 3.931.897 dólares os de Chama 270B (o modelo de linguaxe desenvolvida por META e apoiado por Microsoft).

Neste mesmo informe tamén se fixo unha comparativa entre as emisións de CO2 en toneladas equivalentes entre modelos de aprendizaxe automática e situacións da vida real entre os anos 2020 e 2023. Se 63 coches emiten 63 toneladas de CO2 durante a súa vida útil, o desenvolvemento do modelo de aprendizaxe de GPT-3 (175B) supuxo 500 toneladas no 2020.

Outros estudos, como The growing energy footprint of artificial intelligence (A crecente pegada enerxética da intelixencia artificial), desde Ámsterdam, profundan no consumo de enerxía estimado por solicitude de varios sistemas impulsados por intelixencia artificial en comparación cunha procura estándar de Google. Se unha petición neste buscador implica uns 0,25 watts hora, unha en ChatGPT require 2,90.

Pero, estas cifras apenas chegan ou impactan no usuario. «Ata o de agora primou a visión antropocéntrica», resume a doutora de Dereito da UDC Patricia Faraldo, integrante do equipo. «En Europa hase chegado a un acordo no regulamento sobre intelixencia artificial que deixa fose a variante ambiental dos factores polos que se pode considerar de alto risco a súa implementación. Todo está centrado no ser humano, fai falta unha perspectiva ecocéntrica», alega Faraldo, con experiencia en protección penal do medio ambiente, por unha banda, e na abordaxe dos riscos ético legais da aplicación da intelixencia artificial no campo policial no rastreo de redes sociais, por outro. Dúas áreas que agora integra na cátedra.

Que España aprobase recentemente un Plan Nacional de Algoritmos Verdes é un primeiro paso. «Hai que traballar de arriba abaixo nesta concienciación. Por tanto, hai que empezar polos que desenvolven intelixencia artificial. É fundamental que os propios desenvolvedores implíquense», avisa Faraldo. De aí o valor destes equipos transversais, onde os avogados traballan cos informáticos ou os economistas.

Nesta liña, prosegue Verónica Bolón, «imos estudar as implicacións sociais, éticas e legais dos algoritmos verdes. Por exemplo, na regulación. Ata o momento, o foco está posto en respectar os dereitos das persoas. Pero non imos á dimensión superior, que todo isto tamén contamina. Queremos investigar as propostas de regulación dos países e ver se teñen en conta ao medio ambiente como un ben xurídico a manter», anticipa a investigadora principal da cátedra.

O seu compañeiro, o especialista en robótica Richard Duro, é consciente das reticencias que xeran avances tecnolóxicos e científicos como o campo no que traballan. «É o mesmo que en bioloxía. Non teriamos que temerlle aos clons, senón aos humanos capaces de facelos. Cos robots pasa igual, non son os malos. Os humanos son os malos», asevera Duro.

De momento, o sector privado réxese pola autorregulación e apenas existen normas vinculantes nesta materia. A autoavaliación de riscos e os regulamentos que obriguen ás empresas para ter en conta o respecto ao medio son dous dos seus propósitos. «Non é suficiente con dicir que a intelixencia artificial é un un factor contaminante, trátase de aplicar principios ambientais no seu desenvolvemento, avaliar o risco, previr. Temos que pór os medios para que os algoritmos sexan transparentes, xustos, robustos, explicables e auditables», conclúe a especialista en dereito Patricia Faraldo.

O uso do móbil ou do computador é limpo no sentido de que non producen emisións, pero requiren dun consumo elevado de auga e electricidade. A auga é cada vez máis escasa e a electricidade hai que producila. Os científicos son conscientes de que teñen que visualizalo, sensibilizar acerca dos recursos que implica unha consulta en ChatGPT e o seu adestramento. Difundir estes datos e cal é a meta que perseguen tamén é unha parte esencial do seu traballo.